트위터의 공개 고백... ‘크롭 툴’ 편향성 찾을 시 3500달러 포상 < 테크 < 기사본문 - AI타임스 (aitimes.com)

트위터의 공개 고백... ‘크롭 툴’ 편향성 찾을 시 3500달러 포상 - AI타임스

트위터가 자사 이미지 편집 기능 ‘크롭 툴’ 알고리즘에 내포된 편향 문제를 찾는 공개 경연을 개최했다. 지난 3월 사내 META팀에서 관련 조사를 실시하고, 동일한 데이터가 주어졌을 때 흑인보

www.aitimes.com

- 3월 자사 META팀 편향 발견 이후 공개 경연

- 1위 3500달러·2위 1000달러·3위 500달러 수여

- 일반 참가자 조사 결과, 젊고 흑발에 흰 얼굴 선호

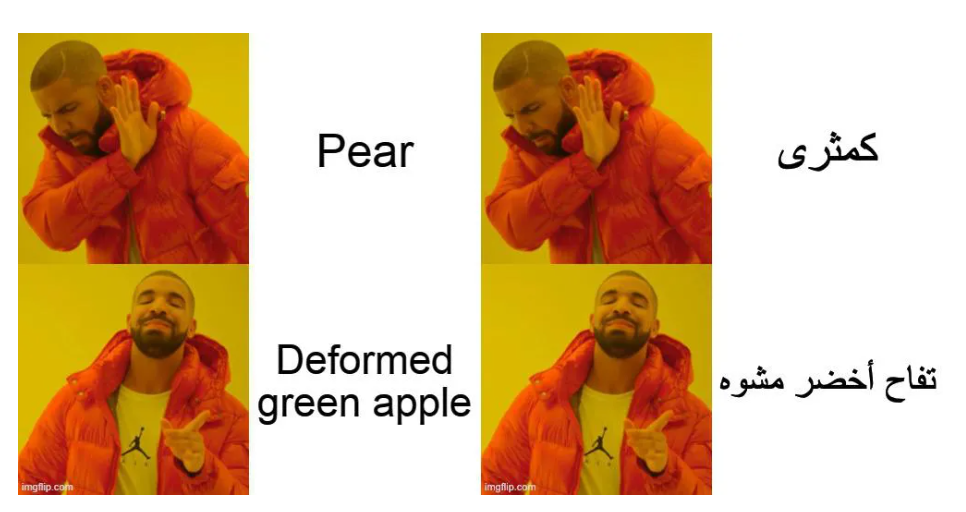

- 아랍어보다 영어 문구 인식해 이미지에 맞게 강조

트위터가 자사 이미지 편집 기능 ‘크롭 툴’ 알고리즘에 내포된 편향 문제를 찾는 공개 경연을 개최했다. 지난 3월 사내 META팀에서 관련 조사를 실시하고, 동일한 데이터가 주어졌을 때 흑인보다 백인의 얼굴을 4% 더 정확하게 구분한다는 결과 이후 중지시킨 지 5개월 만이다.

META는 머신러닝 윤리, 투명과 책임(Machine learning Ethics, Transparency and Accountability)의 앞글자를 따서 지었다. AI스타트업 패리티(Parity) 설립자이자, AI윤리 분야에서 선구자로 정평이 나 있는 루맨 차우드허리(Rumman Chowdhury)가 올 2월 영입돼 이끌고 있다.

IT 전문매체 더버지가 10일(현지시간) 보도한 바에 따르면 트위터는 크롭 툴의 결점을 내부에서 찾아 종결짓기보다 일반 참가자들에게 협조를 구하는 게 옳다고 판단했다. 이에 따라 이번 공모전은 데프콘 AI 빌리지의 지원을 받아 실시하게 됐다.

트위터는 ‘알고리즘 버그 현상금’을 걸고 크롭 툴의 근본적인 편향성부터 잠재적 다른 문제까지 짚어내는 사람에게 1등 3500달러(약 400만원), 2등은 1000달러(약 115만원), 3등 수상자에게는 500달러(약 60만원)를 수여하기로 했다.

1위 수상자는 스위스 로잔 연방 공과대학교(EPFL) 대학원에 재학 중인 보그단 쿨리니히(Bogdan Kulynych)가 뽑혔다. 그는 생성적 적대 신경망(GAN) 기반의 스타일(Style)이라는 프로그램을 사용해 크롭 툴이 가진 문제를 짚어냈다.

쿨리니히는 스타일 프로그램에서 사진 한 장마다 다양한 피부톤을 연출하고 얼굴형이나 이목구비 모양을 조금씩 변형시켜 크롭 툴에 입력시켰다. 이후 크롭 툴 알고리즘이 날씬하고 젊어 보이며 매끄러운 피부결 등 전형적으로 여성스러운 얼굴을 선호해온 것을 발견했다.

결과물을 제출하며 쿨리니히는 “알고리즘은 그동안 체중, 나이, 피부색 등을 규정해 만족도를 충족시키지 못하는 사람의 얼굴은 잘라냈다”는 내용의 개요서도 함께 냈다.

2위는 로마 트레 대학교에서 머신러닝을 연구 중인 빈센조 디 치코(Vincenzo di Cicco)에게 돌아갔다. 치코는 크롭 툴이 백발의 나이 든 얼굴을 보았을 때보다 상대적으로 연령대가 낮은 얼굴의 사진에서 더 잘 기능한다는 것을 증명했다. 피부색도 같은 얼굴이라도 어두운 색보다 밝은 톤을 선호했다.

3위를 수상한 아랍계 미국인 로야 팍자드(Roya Pakzad)는 영어와 아랍어 스크립트를 제작해 크롭 툴이 이미지뿐 아니라 텍스트에서도 편향성을 나타낸 것을 발견했다. 팍자드는 크롭 툴이 각각 영어와 아랍어가 적힌 이미지를 인식한 후 영어가 더 강조돼 보이도록 자동적으로 이미지를 자른 사실을 밝혔다.

더버지는 “공개 경연을 통해 밝혀진 사실이 실망스럽게 보일 수 있지만, 트위터 같은 IT 기업에서 알고리즘 시스템에 대한 사회적 편견이 만연해 있음을 확인시켜주는 것도 중요하다”며 “이렇게 외부 정밀 조사에까지 시스템을 개방하는 것도 트위터로선 큰 도전이었을 것”이라고 평가했다.

실제로 트위터는 크롭 툴 문제가 처음 불거졌던 지난해 9월에는 별다른 조치를 취하지 않았다. 당시 리즈 켈리 커뮤니케이션(홍보팀) 담당자는 “머신러닝이 훈련한 사진 데이터 속 흑인의 얼굴이 충분하지 못했다”며 학습자료가 불충분한 점은 인정하면서도 “자체 편향 테스트 결과, 특정 인종이나 성별을 배제했다는 증거는 발견하지 못했다”고 말했다.

그러나 트위터리안들의 지속적인 문제 제기가 있었고, 이에 차우드허리라는 외부인사를 영입한 것이다. 차우드허리는 이번 대회에 대해 “기업 내부에서는 특정 유형의 피해나 편견을 깊이 파고들 수 없다는 한계점이 존재한다”며 “다각도로 접근해 AI의 편향을 완전히 지울 필요가 있다”고 강조했다.

더버지는 트위터의 이러한 행보에 대해 “이처럼 편향성을 없애려는 개방적 접근은 다른 기술 기업과 대조적”이라고 호평했다. 한 예로 아마존은 MIT 연구진이 자사 얼굴 인식 알고리즘에서 인종과 성별 편견을 발견하자 “명백한 오도이자 허위”라고 주장했다. 그러나 몇 달 동안 이어진 연구 결과, 이는 사실인 것이 밝혀져 아마존은 알고리즘 사용을 일시적으로 중단시켰다.

인공지능 기술이 발달하면서, 직접 사람이 설정하지는 않았겠지만 추측컨대 학습데이터의 양 등으로 인해서 내부 알고리즘에 편향이 생길 수 있다는 점은 충분히 생각할 수 있는 지점이지만, 이게 인종 / 성 / 나이 등 외적으로 보이는 여러 요소들에 있어서 차별적으로 적용될 수 있다는 것은 생각해본 적이 없었다.

MZ 세대는 그 어떤 세대보다 공정 이슈에 민감하다고 한다. (개인적으로는 민감한 집단 vs '불편충'이라며 몰아가는 집단의 갈등이 극대화된 지금이 과도기라고 보지만) 앞으로는 이런 사소해 보이지만 결코 사소하지 않은 부분에서 어떤 서비스가, 어떤 기업이 소비되는지가 갈릴 것이다. 따라서 트위터의 이런 용기있는 행보는 결국 현 소비층에게 '문제를 더 정확하게 짚어 내려고, 또 그 문제의 근본적인 원인을 찾고 해결하려고 노력하는 기업'이라는 이미지를 줄 것이라는 점에서 앞으로 다른 기업들이 유사한 문제에 부딪혔을 때 잡아야 할 방향성을 제시해준다.

'etc > IT 뉴스' 카테고리의 다른 글

| 210819 "의료 데이터 개방, 계속 지연되면 의료 AI 기업 영속 어렵다" (0) | 2021.08.20 |

|---|---|

| [210809] 네이버 "한국어 음성 인식 기술은 클로바가 1등...활용도 계속 높일 것" (0) | 2021.08.16 |

| [210810] KISDI 국내 AI 도입 기업 실태조사..."대기업 제외하면 고작 8%만이 AI기술 활용 중" (0) | 2021.08.13 |

| [210812] SKT-카카오, AI·ESG 협력 본격화...AI 솔루션 개발과 ESG 펀드 조성에 힘 모아 (0) | 2021.08.13 |

| [210812] 통신 3사, 5G·신사업 날개 달고 2분기 이익 1조 돌파...하반기 AI 적용 확대 승부수 (0) | 2021.08.13 |

댓글